今回、RoCE対応スイッチと、実用アプリケーションであるVASPとAmberでベンチマークを取得しました。RoCE環境でInfiniBand-EDR環境に匹敵する性能が得られています。

RoCE環境では、InfiniBand-EDR環境と異なり、ドライバーソフトやMPIのバージョン変更が必要になりますが、リードタイムなどのメリットを勘案すると、注目に値する選択肢と考えられます。

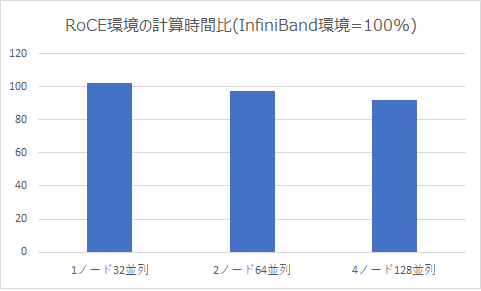

VASPベンチマーク結果

VASPはプロセス間通信が頻発するアプリケーションです。今回は、VASP 5.4.4p1 1,000 atoms (PAW GGA)を使用し、RoCE環境の計算時間比を取得し、InfiniBand-EDR環境と比較しました。

ノード数が増えるほど、RoCE環境のほうが計算時間が少なくてすむ傾向がみえました。

| # | 走行条件 | 計算時間比 |

| 1 | 1ノード32並列 | 102% |

| 2 | 2ノード64並列 | 97.2% |

| 3 | 4ノード128並列 | 91.7% |

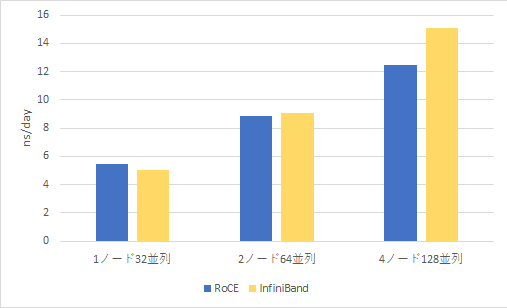

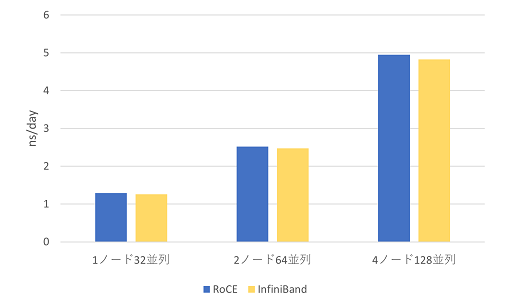

AMBERベンチマーク結果

AmberもVASPほどではありませんがプロセス間通信が発生するアプリケーションです。今回は、Amber20 Cellulose NVE (408,609 atoms, PME)とAmber20 Nucleosome (25,095 atoms, GB)の条件下でInfiniBand-EDR環境との比較を行いました。Amberのns/dayは試行によって±1程度ブレることがあることを考えると、全体的にRoCE環境はInfiniBand-EDR環境と同程度の性能となっています。ただし、Cellulose NVE PMEでの4ノード128並列ではInfiniBand-EDR環境の方が有意に高速に動作しています。

Amber20 Cellulose NVE (408,609 atoms, PME)

| ns/day | 1ノード32系列 | 2ノード64系列 | 4ノード128系列 |

| RoCE | 5.47 | 8.84 | 12.44 |

| InfiniBand | 5.04 | 9.10 | 15.07 |

Amber20 Nucleosome (25,095 atoms, GB)

※Amber20 Nucleosomeの棒グラフの内容が、誤ってAmber20 Cellulose NVEの内容となっておりました。大変申し訳ございませんでした。正しいグラフ内容に差し替えいたしました。(2022年10月26日修正)

| ns/day | 1ノード32系列 | 2ノード64系列 | 4ノード128系列 |

| RoCE | 1.29 | 2.52 | 4.95 |

| InfiniBand | 1.26 | 2.48 | 4.83 |

ベンチマーク環境

RoCE環境

| CPU | Xeon Gold 6326 (2.90GHz 16core) x2cpus |

| メモリ | 32GB DDR4-3200 ECC RDIMM x16dimms |

| NIC | Intel E810 100GbE Ethernet |

| スイッチ | HPC100G-SWR-A-32R |

InfiniBand環境

| CPU | Xeon Platinum 8268 (2.90GHz 24core) x2cpus |

| メモリ | 16GB DDR4-2933 ECC RDIMM x12dimms |

| NIC | Mellanox ConnectX-5 InfiniBand EDR |

| スイッチ | Mellanox SB7800 Switch-IB-2 based EDR InfiniBand 1U Switch |