- 03-5446-5531

- 企業情報

GPU搭載製品

申し訳ございません、対象の製品は見つかりませんでした。

絞り込み条件を取り消して再度お試しください。

-

-

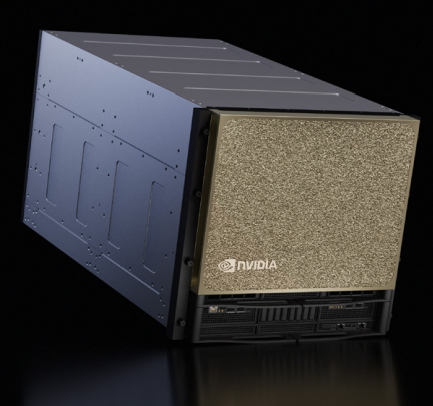

8基のBlackwell Ultra GPUを搭載

飛躍的なAIパフォーマンスを発揮開発からデプロイまで対応する

単一のプラットフォーム14.4 TB/秒の総帯域幅を持つ

NVIDIA NVLink144 petaFLOPS の推論パフォーマンスを実現

-

-

-

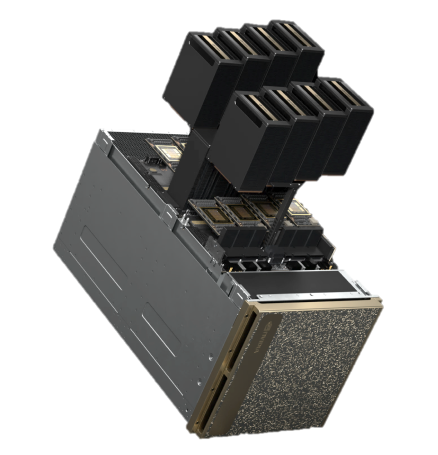

GB10 Superchip Blackwell GPU搭載128GBのコヒーレント統合システムメモリ最大2台のDGX Sparkシステムを

クラスタリング可能標準的なコンセントで駆動

どんなデスクにも簡単に設置可能

-

-

-

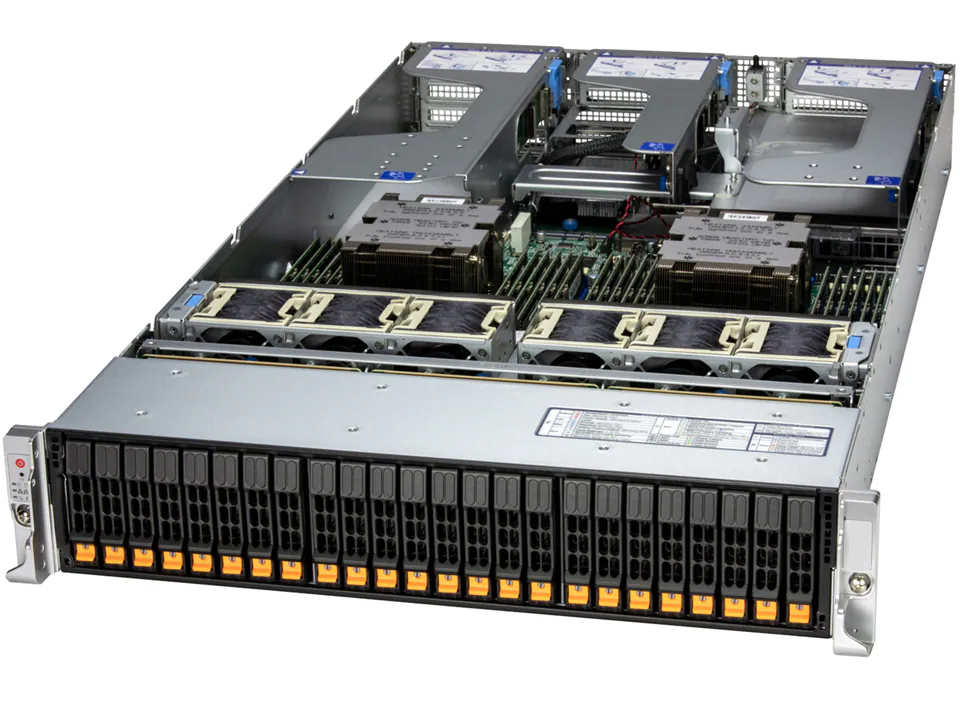

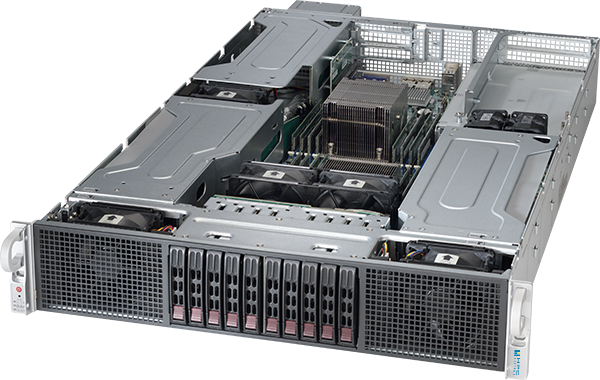

最大64コア(2CPU)GPU2基搭載可最大512GBメモリ2.5型 NVMe SSD 8台搭載可2Uラックマウント最大TDP 250W

-

-

-

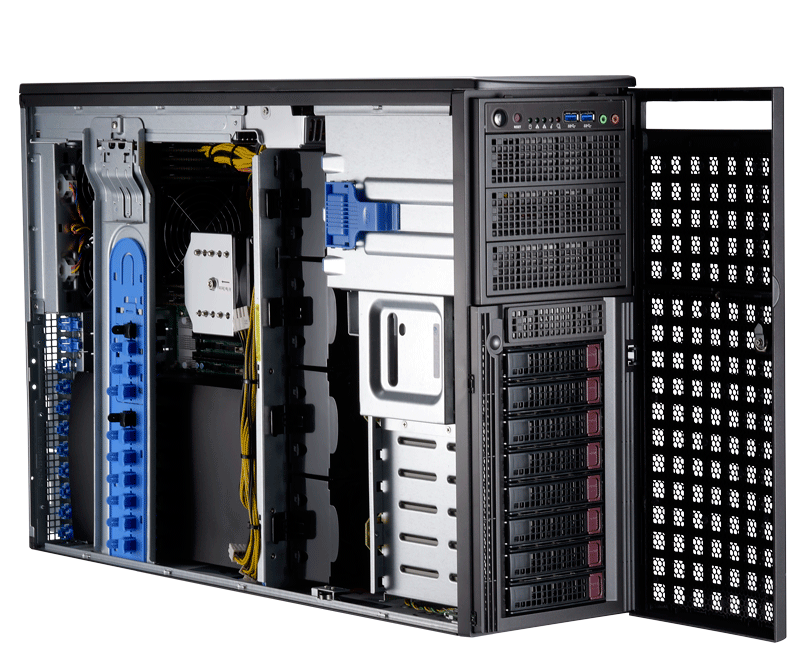

GPU最大2基搭載可最大128コア(2CPU)最大2TBメモリ3.5型 SATA HDD/SSD 8台搭載可タワーType

-

-

-

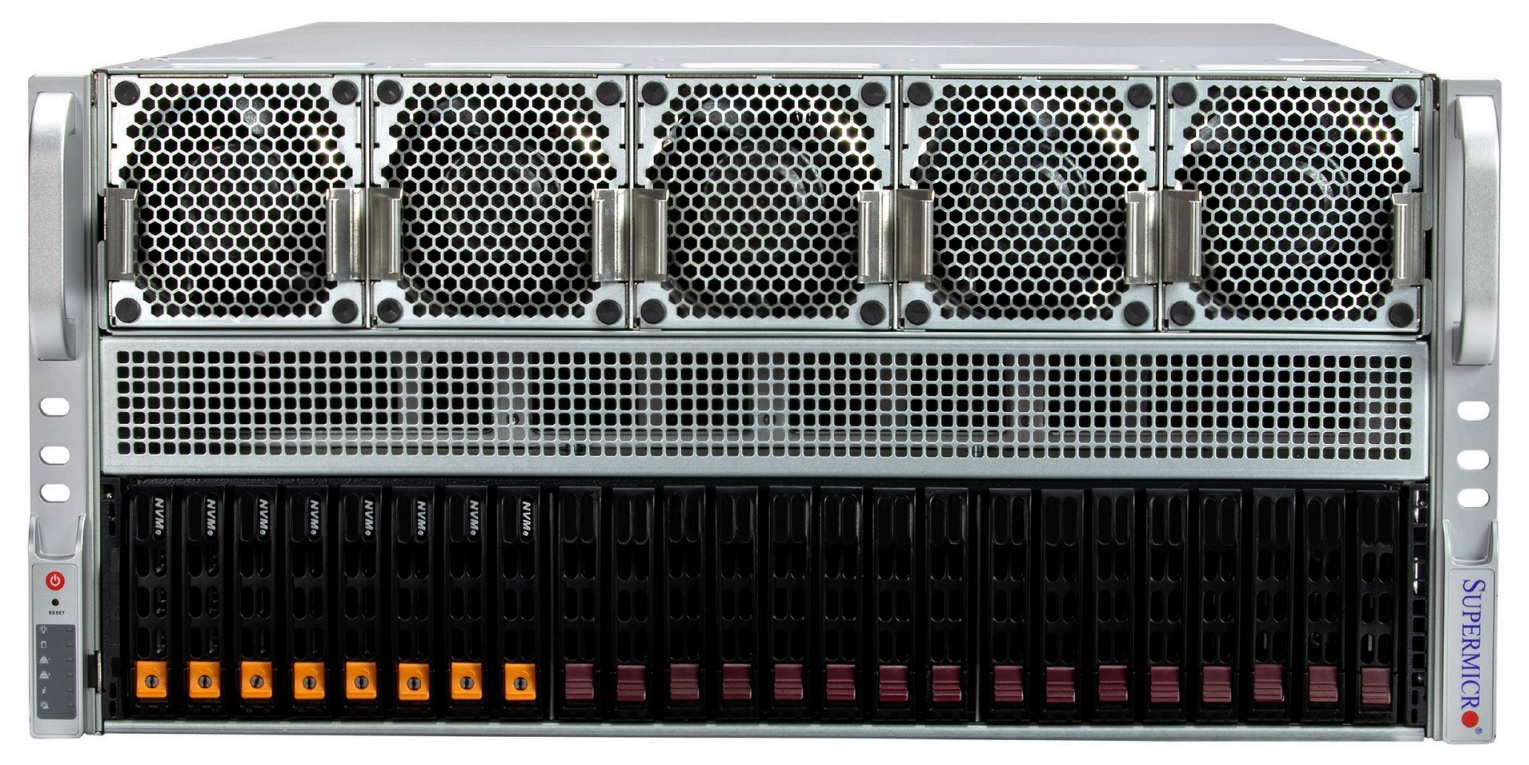

GPU8基搭載可能2CPU(最大172コア)最大4TBメモリ8Uラックマウント

-

-

-

最大64コア(1CPU)GPU4基搭載可最大1TBメモリE1.S NVMe SSD 4台搭載可2Uラックマウント最大TDP 350W

HPC3000-XGRSGPU4R2Sインテル® Xeon® 6 プロセッサー(P-core搭載、開発コード:Granite Rapids-SP)を1基搭載

NVIDIA® GPUを最大4基搭載可能な高性能メインストリームHPCサーバー -

-

-

最大96コア(1CPU)GPU最大4基搭載可能最大1TBメモリ2Uラックマウント最大TDP 350W

-

-

-

最大96コア(1CPU)GPU最大2基搭載最大512GBメモリ最大TDP 350W

HPC3000-TR5PR104TSAMD Ryzen™ Threadripper™ プロセッサを1基搭載、

NVIDIA GPUを最大2基搭載可能なDeep Learning向け高性能GPUワークステーション -

-

-

8基のNVIDIA B200 TensorコアGPU

飛躍的なAIパフォーマンスを発揮開発からデプロイまで対応する

単一のプラットフォーム第 5 世代 NVIDIA® NVLink™ が

NVIDIA Blackwell GPUを相互接続DGX H100 と比較して3倍のトレーニングパフォーマンス、

15倍の推論パフォーマンスを実現

-

-

-

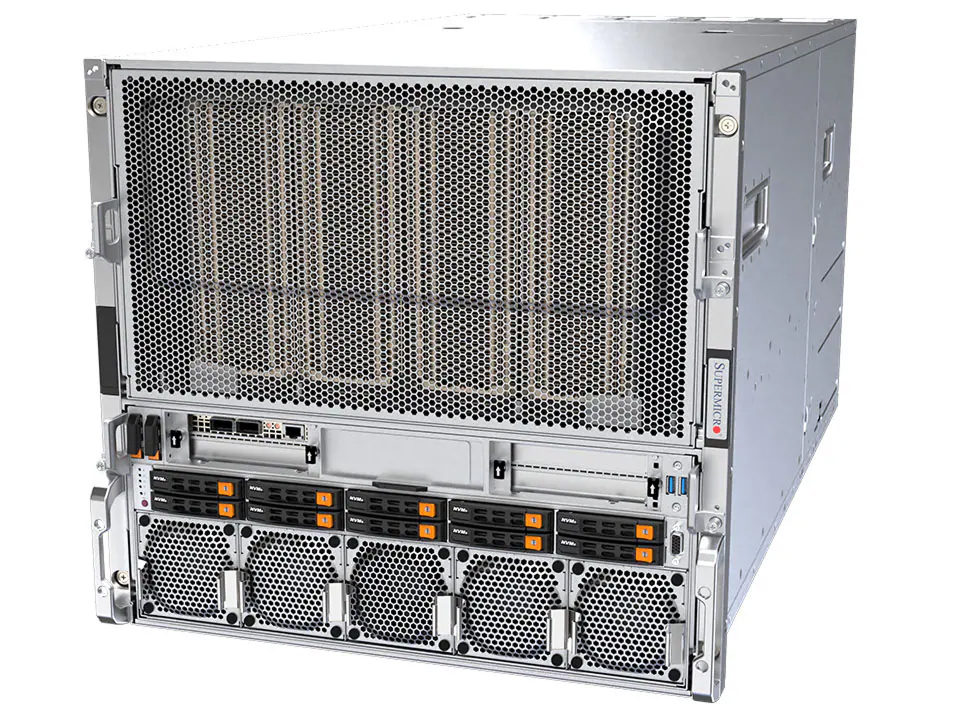

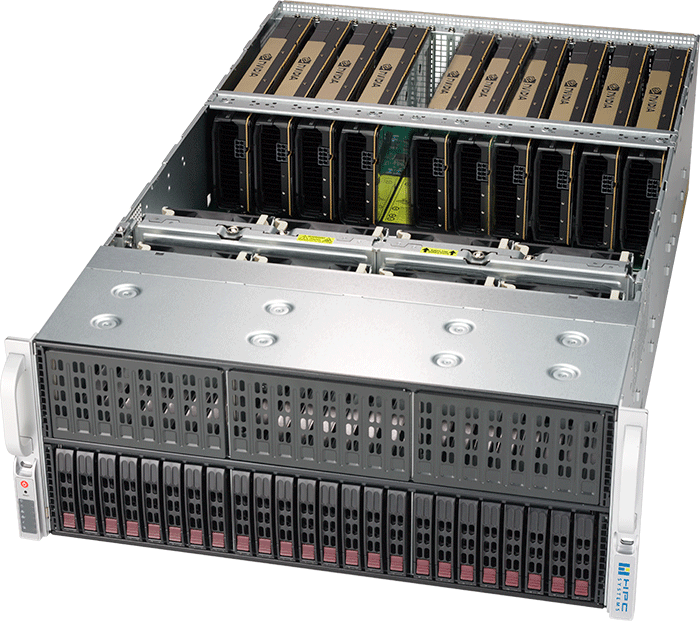

最大320コア(2CPU)GPU8基搭載可能最大6TB2.5インチNVMe/SATAドライブ 24台搭載可4Uラックマウント

-

-

-

最大256コア(2CPU)GPU8基搭載最大3TBメモリ最大20台のドライブ搭載可能10Uラックマウント最大TDP 400W

-

-

-

最大96コア(1CPU)GPU最大2基搭載最大512GBメモリ最大TDP 350W

HPC3000-TR4PR104TSAMD Ryzen™ Threadripper™ プロセッサを1基搭載、

NVIDIA GPUを最大2基搭載可能なDeep Learning向け高性能GPUワークステーション -

-

-

GPU4基搭載可能最大192コア(1CPU)最大6TBメモリHDD/SSD12台搭載可2Uラックマウント最大TDP 400W

-

-

-

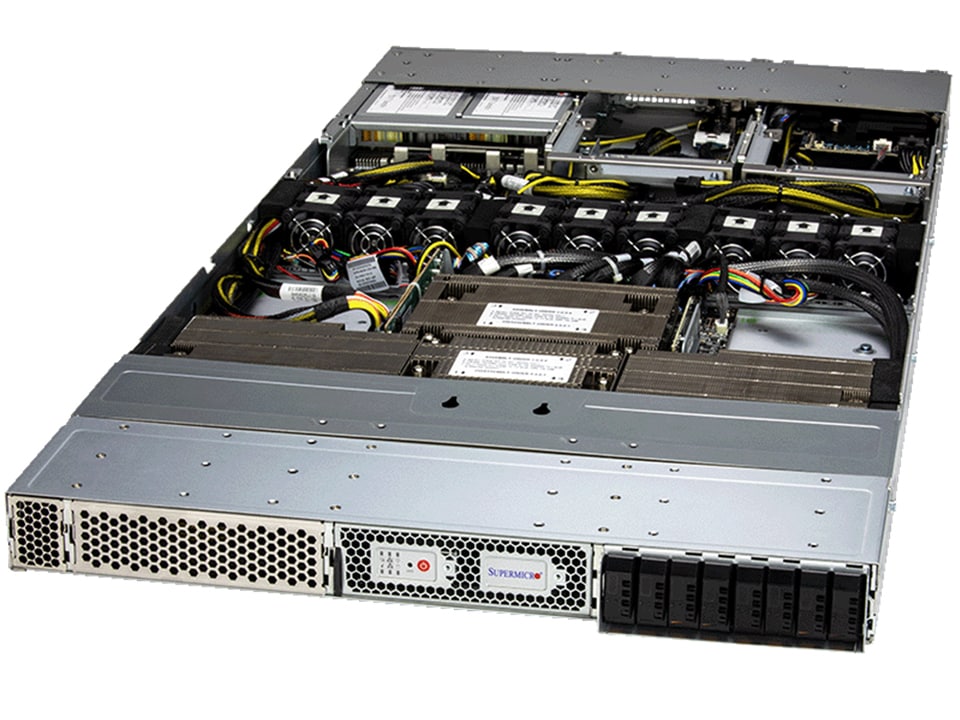

2CPU(最大256コア)GPU8基搭載可能最大3TBメモリ3UラックマウントTDP 500W

-

-

-

2CPU(最大256コア)GPU8基搭載可能最大3TBメモリE1.S NVMe SSD 8台搭載可4UラックマウントDual Root ComplexTDP 500W

-

-

-

インテル® Core™ Ultra プロセッサーGPU1基搭載可能最大128GBメモリ3.5 HDD×2 / 2.5 SSD×4搭載可能タワーType最大TDP 125W

販売終了製品:HPC2000-CARL104TSインテル® Core™ Ultra プロセッサー (シリーズ2) 搭載

Geforce RTX 50 シリーズ対応 エントリーHPCワークステーション -

-

-

最大96コア(1CPU)GPU最大4基搭載可能最大1TBメモリ2Uラックマウント最大TDP 350W

-

-

-

最大382コア(2CPU)GPU8基搭載最大3TBメモリ最大20台のドライブ搭載可能10Uラックマウント最大TDP 500W

-

-

-

最大256コア(2CPU)GPU8基搭載可能最大3TBメモリ10UラックマウントTDP 500W

-

-

-

最大128コア(2CPU)GPU8基搭載可能最大4TBメモリ10UラックマウントTDP 350W

-

-

-

2CPU(最大256コア)GPU10基搭載可能最大3TBメモリ5UラックマウントTDP 500W

HPC5000-XGRAGPU10R5Sインテル® Xeon® 6 プロセッサー(P-core搭載)2基搭載

NVIDIA® GPUを最大10基搭載可能な

Deep Learning向けハイエンドGPUサーバー -

-

-

水冷式冷却機構最大56コア(1CPU)最大512GBメモリGPU4枚搭載可

-

-

-

最大384コア(2CPU)GPU10基搭載可最大3TBメモリSATA/NVMe ドライブ10台搭載可5Uラックマウント最大TDP 500W

HPC5000-ETNGPU10R5S-AAMD EPYC™ (Turin)プロセッサーを2基搭載し、NVIDIA® GPUを最大10基搭載可能

Deep Learning向けハイエンドGPUサーバー -

-

-

最大384コア(2CPU)GPU8基搭載可最大1.5TBメモリ

※評価中SATA/NVMe ドライブ6台搭載可5UラックマウントTDP500W

-

-

-

最大60コア(1CPU)GPU2基搭載可最大512GBメモリ水冷式冷却機構SATA SSD 2台/NVMeSSD 2台 搭載可最大TDP 385W

-

-

-

最大160コア(1CPU)GPU2基搭載可最大1.5TBメモリNVMe/SATAドライブ12台搭載可2Uラックマウント最大TDP 400W

-

-

-

最大384コア(2CPU)GPU最大3基搭載可最大6TBメモリNVMe/SATA/SASドライブ24台搭載可2Uラックマウント最大TDP 500W

-

-

-

最大128コア(2CPU)GPU8基搭載可最大4TBメモリNVMe 16台 / SATA SSD 8台 搭載可4Uラックマウント最大TDP 350W

-

-

-

最大128コア(2CPU)GPU最大10基搭載可最大4TBメモリSATA SSD 8台 / NVMe 8台 搭載可5UラックマウントDual Root Complex最大TDP 350W

-

-

-

最大120コア(2CPU)GPU最大10基搭載可最大4TBメモリSATA SSD 8台 / NVMe 8台 搭載可5UラックマウントDual Root Complex最大TDP 350W

-

-

-

水冷式冷却機構最大72コア(2CPU)最大512GBメモリGPU最大2基搭載可SATA SSD 2台/NVMeSSD 2台 搭載可最大TDP 300W

-

-

-

水冷式冷却機構最大104コア(2CPU)最大512GBメモリGPU最大2基搭載可SATA SSD 2台/NVMeSSD 2台 搭載可最大TDP 300W

-

-

-

最大128コア(2CPU)GPU4基搭載可最大4TBメモリSSD/NVMe 8台搭載可2Uラックマウント最大TDP 350W

-

-

-

最大120コア(2CPU)GPU4基搭載可最大4TBメモリSSD/NVMe 8台搭載可2Uラックマウント最大TDP 350W

-

-

-

最大72コア(1CPU)GPU1基搭載可E1.S NVMe 2台 /

M.2 NVMe SSD 2台搭載可能1Uラックマウント

-

-

-

最大128コア(2CPU)GPU4基搭載可最大2TBメモリSSD/NVMe 8台搭載可4Uラックマウント最大TDP 350W

-

-

-

最大128コア(2CPU)最大1TBメモリHDD/SSD 4台搭載可GPU最大1基搭載可タワーType(6Uラックマウント)最大TDP 350W

-

-

-

最大128コア(2CPU)GPU10基搭載可最大4TBメモリNVMe/SATA/SASドライブ8台搭載可4UラックマウントDual Root Complex最大TDP 350W

-

-

-

最大72コア(2CPU)GPU4基搭載可最大2TBメモリ3.5型 SAS/SATA HDD、

2.5型 SATA SSD/NVMe8台搭載可タワーType

-

-

-

最大256コア(2CPU)GPU10基搭載可最大3TBメモリ搭載可HDD/SSD24台搭載可4Uラックマウント

-

-

-

最大16コア(1CPU)GPU最大4基搭載可最大1TBメモリHDD/SSD 8台搭載可TDP400W

HPC3000-EGNGPU4TCAMD EPYC™ (Genoa)プロセッサーを1基搭載、NVIDIA® GPUを最大4基搭載可能

Deep Learning向けハイエンドGPUワークステーション -

-

-

第13世代インテル® Core™ i9DDR5-4800対応

最大128GBメモリタワーTypeGPU搭載可能<img src="/product/wp-content/uploads/sites/3/2023/02/win11.png" height="16px" width="87px" style="margin-bottom:2px; margin-right:2px;"> 対応

-

-

-

第13世代インテル® Core™ i9GPU搭載可DDR5-4800対応

最大128GBメモリタワーType<img src="/product/wp-content/uploads/sites/3/2023/02/win11.png" height="16px" width="87px" style="margin-bottom:2px; margin-right:2px;"> 対応

-

-

-

最大64コア(2CPU)GPU最大2基搭載可最大2TBメモリHDD/SSD 8台搭載可

-

-

-

最大60コア(1CPU)最大1TBメモリHDD/SSD 6台搭載可タワーTypeTDP350WGPU最大4基搭載可

-

-

-

最大80コア(2CPU )GPU最大2基搭載可最大512GBメモリHDD4台搭載可ミドルタワーtype

-

-

-

最大60コア(1CPU)最大2TBメモリタワーType

-

-

-

AMD RyzenGPU搭載可能最大1TBメモリタワーTypeIPMI2.0標準搭載

販売終了製品:HPC3000-TRPR108TSAMD Ryzen Thread Ripper Proプロセッサー搭載、

NVIDIA GPU最大4基搭載可能なDeep Learning向け

ハイエンドGPUワークステーション

-

-

-

最大80コア(2CPU)GPU最大1基搭載可最大2TBメモリHDD/SSD 4台搭載可タワーType

-

-

-

最大80コア(2CPU)GPU4基搭載可能最大2TBメモリタワーTypeIPMI2.0標準搭載

-

-

-

最大120コア(2CPU)GPU4基搭載可能最大2TBメモリタワーType

-

-

-

最大128コア(1CPU)GPU10基搭載可能最大3TBHDD/SSD8台搭載可4Uラックマウント

-

-

-

最大120コア(2CPU)GPU10基搭載可能最大4TBメモリ4Uラックマウント

-

-

-

GPU8基搭載可能最大4TBメモリ4Uラックマウント

-

-

-

最大256コア(2CPU)GPU8基搭載可能最大3TBIPMI2.0標準搭載HDD/SSD24台搭載可4Uラックマウント

-

-

-

最大192コア(2CPU)GPU8基搭載可能最大3TBHDD/SSD24台搭載可4Uラックマウント

-

-

-

最大160コア(1CPU)最大1.5TBメモリGPU2基搭載可NVMe/SATAドライブ 12台搭載可1Uラックマウント

-

-

-

第12世代Core™ i9DDR5-4800対応

最大128GBメモリタワーTypeGPU搭載可能<img src="/product/wp-content/uploads/sites/3/2023/02/win11.png" height="16px" width="87px" style="margin-bottom:2px; margin-right:2px;"> 対応

-

-

-

GPU最大2基搭載可最大80コア(2CPU)最大2TBメモリHDD8台搭載可タワーType

-

-

-

水冷GPU4基搭載可能最大64コア(2CPU)最大1TBメモリタワーTypeIPMI2.0標準搭載

-

-

-

8基のNVIDIA H100 TensorコアGPUに

より32 PFLOPS のAI演算性能すべてのAIワークロードに対応する

ユニバーサルシステム7.2 テラバイト/秒の GPU 間双方向帯域幅H100 TensorCore

データ分析、高性能コンピューティングで

これまでにない加速

-

-

-

GPU6基搭載可能最大2TBメモリ2UラックマウントIPMI2.0標準搭載

-

-

-

GPU4基搭載可能最大40コア(1CPU)最大2TBメモリタワーTypeIPMI2.0標準搭載

-

-

-

GPU10基搭載可能最大4TBメモリ4UラックマウントIPMI2.0標準搭載

-

-

-

AMD EPYC™2CPUメモリ最大4TBGPU8基搭載可能4UラックマウントIPMI2.0標準搭載

販売終了製品:HPC5000-EMLGPU8R4SAMD EPYC™ 7003シリーズ (Milan)プロセッサーを2基搭載、NVIDIA® GPUを8基搭載可

4Uサイズ・Gen4対応のスーパーハイエンドGPUラックマウントサーバー -

-

-

GPU4基搭載可能最大64コア(1CPU)最大1TBメモリPCI-Express 4.0対応IPMI2.0標準搭載

-

-

-

GPU5基搭載可能最大56コア(2CPU)最大1.5TBメモリタワーTypeIPMI2.0標準搭載

-

-

-

GPU4基搭載可能最大28コア(1CPU)最大768GBメモリタワーTypeIPMI2.0標準搭載

-

-

-

最大64コア(1CPU)最大1TBメモリHDD2台搭載タワーTypeIPMI2.0標準搭載GPU最大4基搭載可

-

-

-

8基のNVIDIA A100 TensorコアGPUにより5 PFLOPS のAI演算性能すべてのAIワークロードに対応するユニバーサルシステムGPU用メモリは帯域幅12.4TB/秒A100 TensorCore

データ分析、高性能コンピューティングで

これまでにない加速

-

-

-

GPU4基搭載可能最大56コア(2CPU)最大1.5TBメモリタワーTypeIPMI2.0標準搭載

-

-

-

GPU4基搭載可能最大28コア(1CPU)最大768GBメモリ1UラックマウントIPMI2.0標準搭載

-

-

-

GPU最大20基搭載最大3TBメモリ4UラックマウントIPMI2.0標準搭載

-

-

-

GPU10基搭載可能最大3TBメモリ4UラックマウントIPMI2.0標準搭載

-

-

-

GPU8基搭載可能最大3TBメモリ4UラックマウントIPMI2.0標準搭載

-

-

-

GPU8基搭載可能最大56コア(CPU)最大1.5TBメモリ2UラックマウントIPMI2.0標準搭載

-

-

-

GPU6基搭載可能最大1.5TBメモリ2UラックマウントIPMI2.0標準搭載

-

-

-

GPU4基搭載可能最大56コア(2CPU)最大1.5TBメモリ1UラックマウントIPMI2.0標準搭載

-