NVIDIA DGX Series

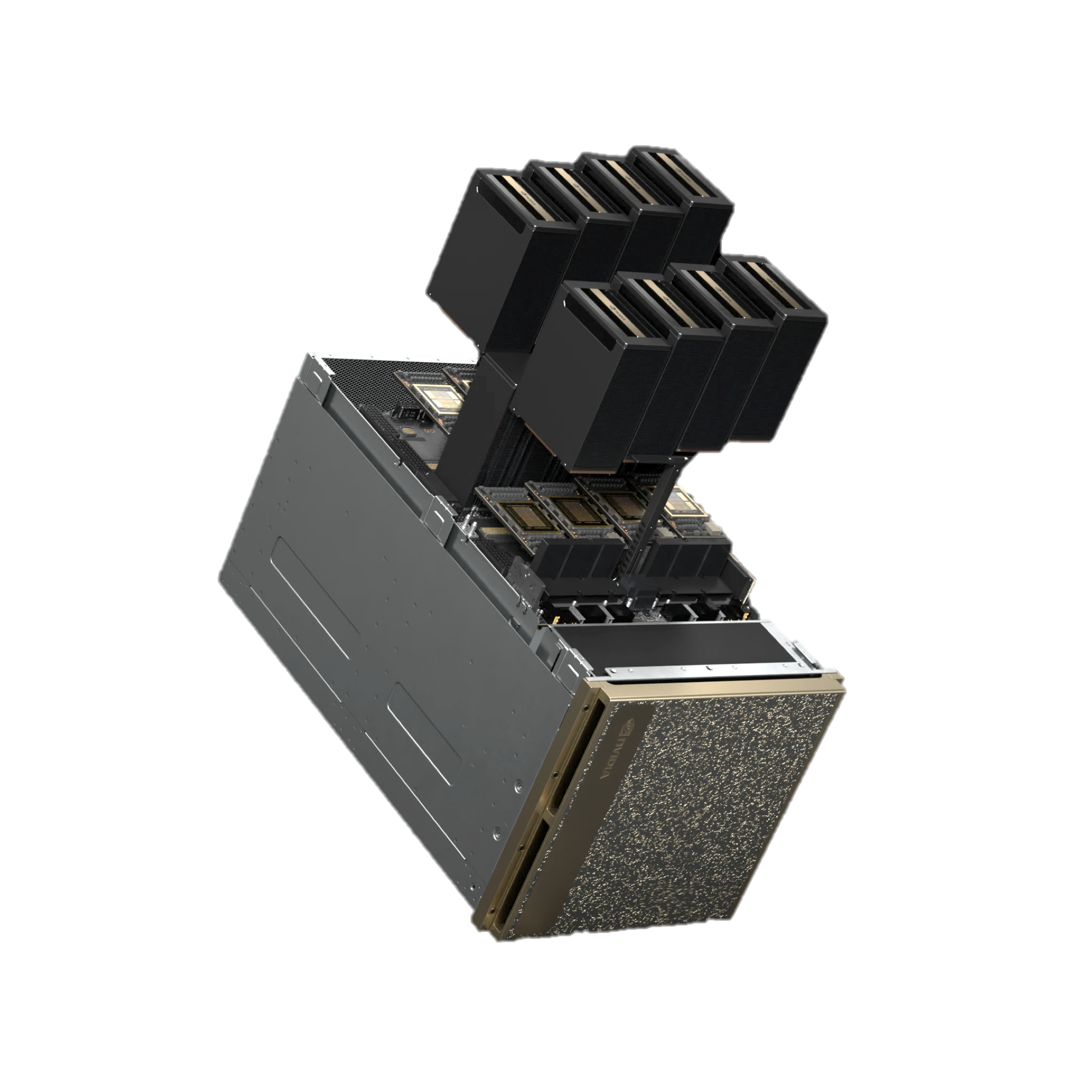

卓越したAI センターの基盤 NVIDIA DGX B200

画期的な技術革新がもたらす革新的な効率性

NVIDIA Blackwell GPU アーキテクチャを採用した次世代のDGXシステム

膨大なGPUメモリで企業規模を問わずAI導入を支援大規模言語モデル、レコメンドシステム、チャットボットなど多様なデータ処理に対応

飛躍的な学習・推論パフォーマンスの向上

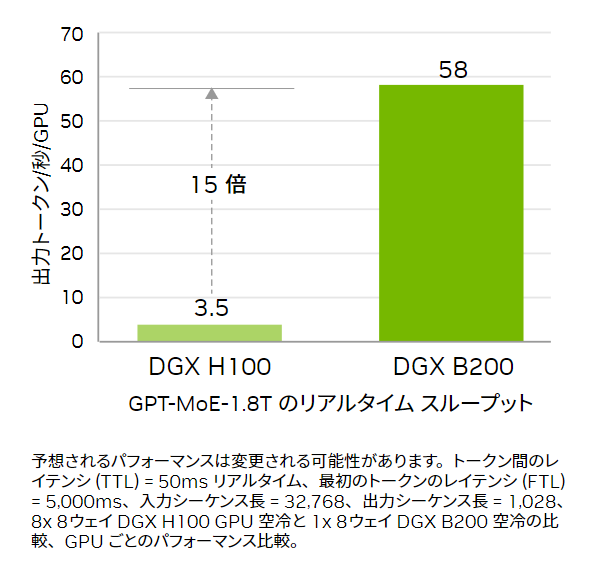

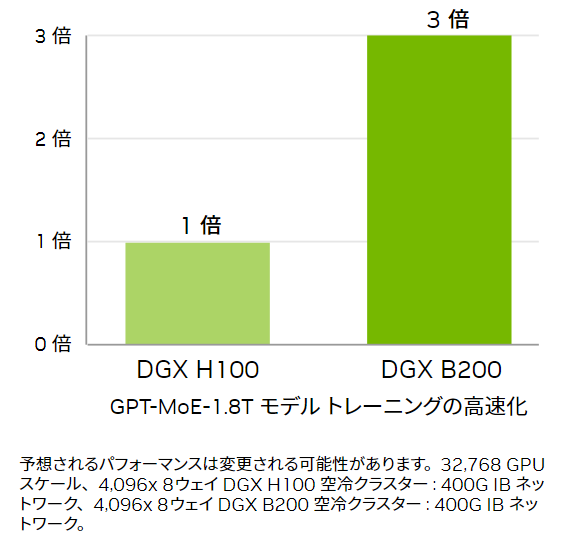

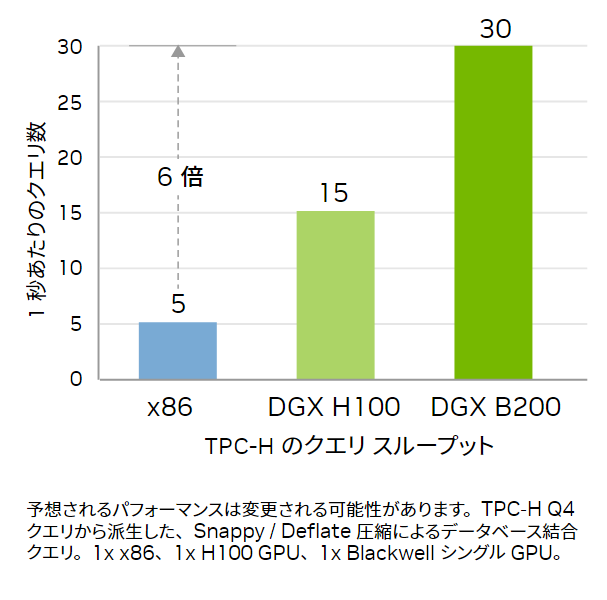

前世代と比較してトレーニング性能は 3 倍、推論性能は 15 倍の最先端の性能を実現双方向帯域幅合計1.8TB/s(テラバイト毎秒)性能を備えた第5世代NVIDIA NVLink®

最大18本のNVLink 100GB/sの接続による高速通信NVIDIA CONNECTX®-7 NIC および、NVIDIA BLUEFIELD® DPU 400Gb/秒 ネットワーク インターフェイスx2

ピーク時の双方向ネットワーク帯域幅 1.6TB/秒の高速AIパフォーマンスデュアル 第5世代 Intel Xeon Platinum 8570 プロセッサ、合計 112 個のコア、最大4TBのシステムメモリ

AIのハイパフォーマンスを可能にするパワフルな CPU 製品概要

製品概要

NVIDIA DGX™ B200 は、企業規模に関係なく、AI 導入の全段階をサポートする統合 AI プラットフォームです。

8 基の NVIDIA B200 TensorコアGPUが第5世代の NVIDIA® NVLink® で相互接続されており、前世代と比べてトレーニング性能は3倍、推論性能は15倍に向上しています。

NVIDIA Blackwell GPU アーキテクチャを採用し、大規模言語モデルやレコメンダーシステム、チャットボットなどの多様なワークロードを処理できるため、AI トランスフォーメーションを加速したい企業に最適です。

主な特長

主な特長

開発からデプロイまでを支える単一のプラットフォーム

企業は日々の業務や顧客体験向上のためにAIを導入することが可能です。

突き抜けたAIパフォーマンス

DGX B200はNVIDIA Blackwell アーキテクチャの高度なコンピューティングを活用し、DGX H100と比べて3倍のトレーニング性能と、15倍の推論性能向上を達成。 NVIDIA DGX BasePOD™ と NVIDIA DGX SuperPOD™ を支える優れた高速性と拡張性を提供し、最先端のパフォーマンスを発揮します。

信頼性の高いインフラを利用可能

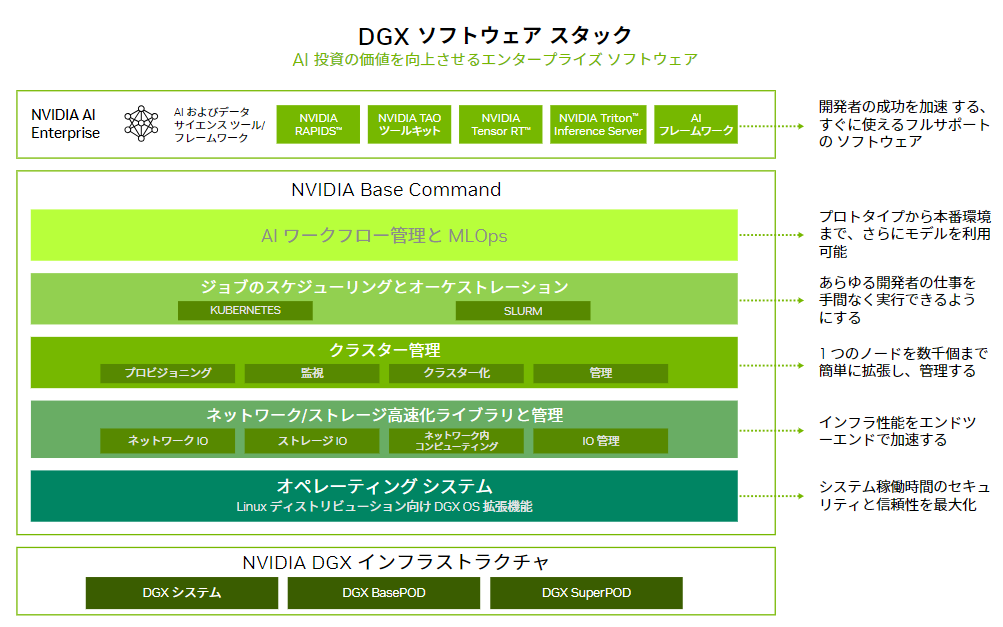

NVIDIA Base Command 搭載

システム解説

システム解説

NVIDIA RTX BLACKWELL GPU アーキテクチャは、従来のNVIDIA GPUで導入されたAI技術を基盤とし、次世代のAIを活用したプロフェッショナルアプリケーションを可能にします。

Blackwell第5世代Tensorコアは、AIやHPCアプリケーションで使用される行列の乗算と累算の演算に特化した高性能コンピュータコアです。ディープラーニング・ニューラルネットワークのトレーニングと推論の両方に不可欠な行列計算に対して、画期的な性能を提供します。RTX Blackwell Tensorコアは、FP16、BF16、TF32、INT8、およびHopperのFP8トランスフォーマ・エンジンをサポートしています。RTX Blackwellは、FP4およびFP6テンソル・コア演算の新しいサポートと、データセンター・クラスのBlackwell GPUと同様の新しい第2世代FP8トランスフォーマ・エンジンを追加します。

仕様・スペック

仕様・スペック

| SYSTEM | NVIDIA DGX B200 |

| GPU | 8x NVIDIA B200 Tensor Core GPUs(メモリ180GB/1GPU) |

| GPU memory | 合計1,440GB |

| Performance | 72 petaFLOPS FP8 トレーニング 144 petaFLOPS FP4 推論 |

| NVIDIA® NVSwitch™ | 2x |

| System power usage | 最大14.3 kW |

| CPU | Dual Intel® Xeon® Platinum 8570 Processors x2 合計112 コア, 2.10 GHz (ベース), 4.0 GHz (最大ブースト) |

| System memory | 最大4TB |

| Cluster Network | 4 個の OSFP ポートで 8 個のシングルポートを提供する NVIDIA ConnectX-7 VPI > 最大 400Gb/秒の InfiniBand/Ethernet |

| Storage Network | 2 個のデュアルポート QSFP112 NVIDIA BlueField-3 DPU > 最大 400Gb/秒の InfiniBand/Ethernet |

| Management Network | 10Gb/秒のオンボード NIC (RJ45 搭載) 100Gb/秒のデュアルポート イーサネット NIC ホスト BMC (ベースボード管理コントローラー、RJ45 搭載) |

| Storage | OS: 2 個の 1.9TB NVMe M.2 内部ストレージ: 8 個の 3.84TB NVMe U.2 |

| System software | NVIDIA AI Enterprise – 最適化された AI ソフトウェア NVIDIA Base Command™ – オーケストレーション、スケジューリング、 クラスター管理 DGX OS / Ubuntu – オペレーティング システム |

| Rack Unit | 10RU |

| System dimensions | 高さ: 17.5in (444mm) 幅: 19.0in (482.2mm) 長さ: 35.3in (897.1mm) |

| Operating temperature range | 5–30°C (41–86°F) |

| Business Support | ハードウェアとソフトウェアの3年間のエンタープライズBusiness-Standardサポート 年中無休のエンタープライズサポートポータルアクセス 現地営業時間中のライブエージェントサポート |

NVIDIA Partner Network(NPN)に認定されました

HPCシステムズは、NVIDIA社のパートナー認定制度 “NVIDIA Partner Network (NPN)” において、「DGX AI Compute System」 「Networking」 「Compute」 の3つのコンピテンシーで最上位レベルのELITE PARTNER に認定されています。

HPC システムズは、Solution Provider と Solutions Integration Partner の二つのパートナーカテゴリーをカバーする製品知識と、長年培ってきた高度な HPC-AI システムインテグレーション技術を掛け合わせることで、お客様の研究・開発の加速化、効率化に対する最適解を提供してまいります。

※ NVIDIA パートナー ネットワーク (NPN) は、NVIDIA が展開するパートナープログラムです。 2024年7月現在、日本国内の企業が約80社加入しています。 NVIDIA パートナー ネットワーク (NPN) は、13種類のパートナーのタイプと、11種類のコンピテンシーで構成されています。

ご参考: NVIDIA パートナー ネットワーク (NPN)

お問い合わせ

お客様に最適な製品をご提案いたします。まずはお気軽にお問い合わせください。

03-5446-5531

平日9:00~18:00(土・日・祝日は除きます)

※土曜日、日曜日、祝日、年末年始は、休日とさせていただきます。