NVIDIA

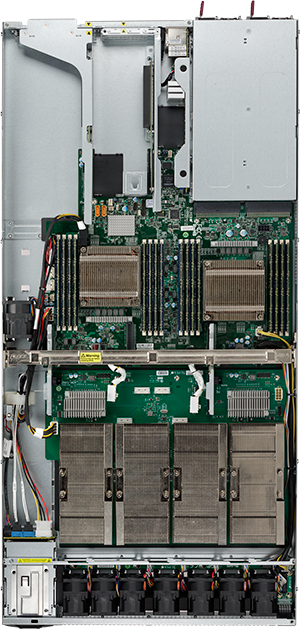

V100 NVLink対応モデルを

4基搭載可能

V100 NVLink対応モデルを

4基搭載可能

| OS | 【HPC向け】CentOS, Red Hat Enterprise Linux 【Deep Learning向け】 Ubuntu ※Windowsを希望される場合は、別途ご相談ください。 |

|---|---|

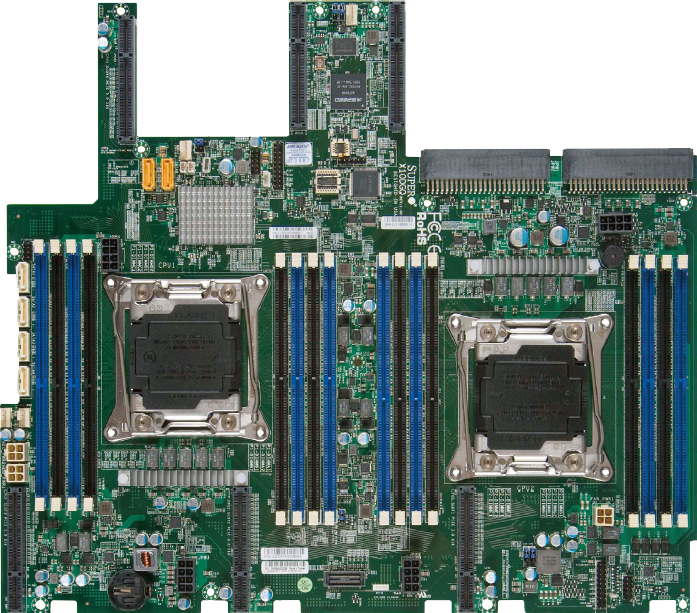

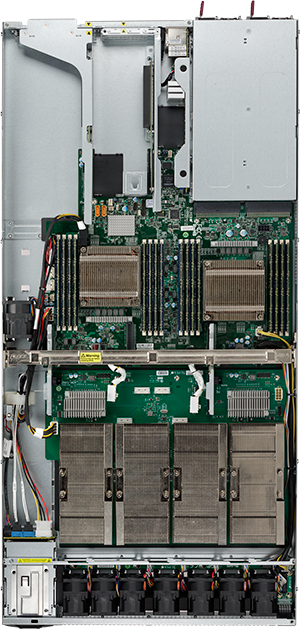

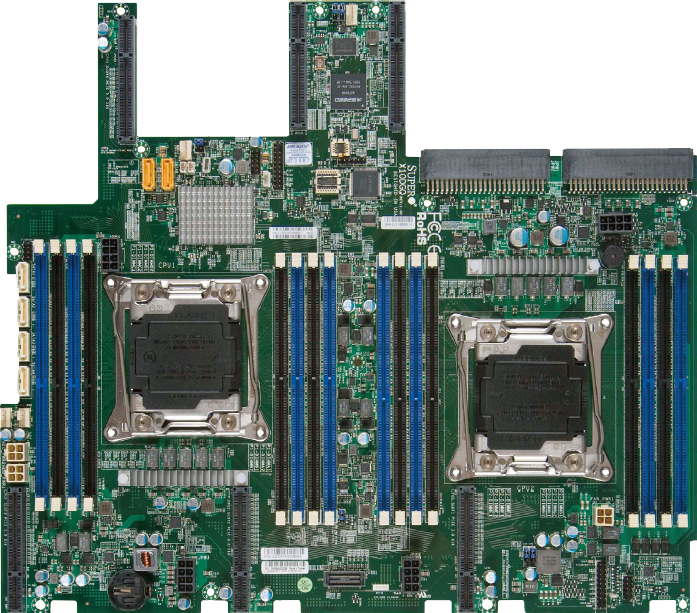

| プロセッサー | インテル® Xeon® プロセッサー E5-2600 v4 ファミリー ※CPUモデル(プロセッサー・ナンバー)によって設置環境に制限があります。詳細はお問い合わせください。 ※E5-2687W v4 / 2667 v4 / 2643 v4 / 2637 v4 / 2623 v4 は搭載できません。 |

| プロセッサー搭載数 | 2CPU(44コア) |

| プロセッサー冷却方式 | 空冷式 |

| チップセット | インテル® C612 |

| メモリ | 1TB (64GB DDR4 LRDIMM-2400 Registered ECC ×16) 512GB (32GB DDR4 2400 Registered ECC ×16) 256GB (16GB DDR4 2400 Registered ECC ×16) 128GB (16GB DDR4 2400 Registered ECC ×8) 64GB (8GB DDR4 2400 Registered ECC ×8) |

| メモリスロット | 16DIMMスロット/DDR4 LRDIMM-2400 Registered ECC (64GB), DDR4 2400 Registered ECC (8,16,32GB) |

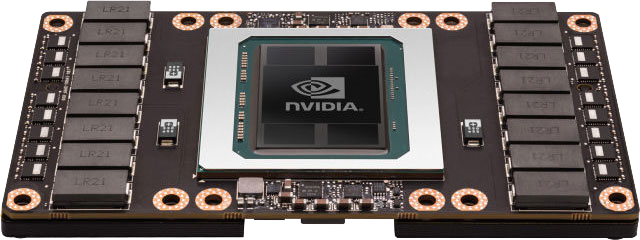

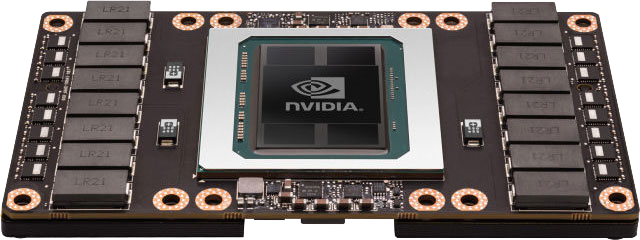

| GPU | NVIDIA V100 for NVLink-enabled Servers 32GB NVIDIA V100 for NVLink-enabled Servers 16GB |

| GPU搭載数 | 4基 |

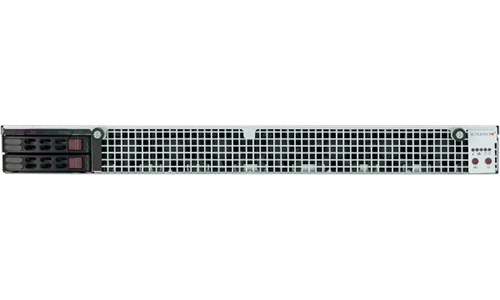

| ハードディスクドライブ | 標準:240GB SSD (2.5型, SATA) ×2 ※HDD/SSD (2.5型, SATA) を最大2台搭載可能 ※RAIDアレイコントローラー (オプション) 増設時、SAS HDD使用可能 |

| 光学ドライブ | なし |

| グラフィックス | Aspeed AST2400 |

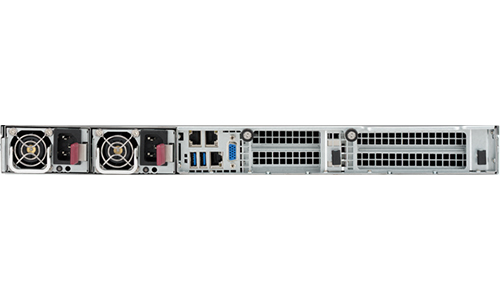

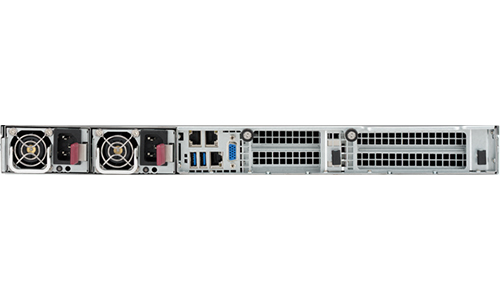

| インターフェイス | VGA [D-sub15ピン] (背面) ×1 ※ビデオカード搭載時は出力機能をOFFに設定します。 USB3.0 (背面) ×2 ネットワーク [GbEポート] (背面) ×2 IPMI2.0ポート [RJ45] (背面) ×1 |

| 拡張スロット | PCI-Express 3.0 (x16) ×3, PCI-Express 3.0 (x8) ×1 (Low Profile) |

| 電源ユニット | 2000W 冗長化電源 (80PLUS TITANIUM認証取得) |

| ACケーブル | 200V用ACケーブルを2本添付/ IEC320-C13 ⇒ IEC320-C14 |

| ACコネクタタイプ | IEC 320-C14 |

| 最大消費電力 | 1826W |

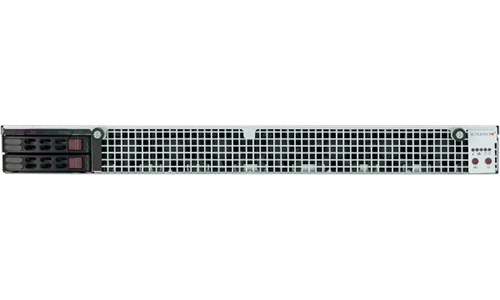

| 筐体タイプ | ラックマウントタイプ (1U) |

| サイズ (縦幅×横幅×奥行) | 43mm × 437mm × 894mm ※筐体の奥行きがあるため、使用できるラックに制限があります。詳細はお問い合わせください。 |

| 重量 | 16kg |

| 附属品 | 200V用ACケーブル ×2 USBキーボード (日本語または英語) ×1 USB光学式スクロールマウス ×1 取扱説明書 保証書 |

| 保証 | 3年間センドバック保守 |

| オプション | RAIDアレイコントローラー |

|---|---|

| 2.5型 SSD (フラッシュメモリドライブ) | |

| InfiniBand HCA | |

| 各種ディスプレイ |

※会社名及び製品名等は、当社及び各社の商標または登録商標です。価格、写真、仕様等は予告なく変更する場合があります。製品の色調及び仕様は実際と異なる場合があります。

平日9:30~17:30 (土曜日、日曜日、祝祭日、年末年始、夏期休暇は、休日とさせていただきます。)